Künstliche Intelligenz (KI/AI)

Künstliche Intelligenz (KI) ist längst kein Zukunftsthema mehr, sondern prägt bereits heute zahlreiche Branchen und Unternehmensprozesse. Der AI Act der Europäischen Union (europäische Verordnung über künstliche Intelligenz) reguliert den Einsatz und verpflichtet Unternehmen, verbotene Systeme abzuschalten, Mitarbeiter zu schulen und weitere Maßnahmen zu ergreifen.

Für Unternehmen, IT-Entscheider und Mitarbeiter eröffnet KI neue Möglichkeiten, um Effizienz und Produktivität zu steigern, Innovationen voranzutreiben und Wettbewerbsvorteile zu sichern. Die solide geplante Integration von KI-Technologien in Geschäftsprozesse ist daher nicht nur Trend, sondern essenziell für die ➔ digitale Souveränität und die nachhaltige Wettbewerbsfähigkeit von Unternehmen.

Den Chancen von KI stehen aber auch Risiken gegenüber, die im Auge behalten werden sollten.

Dabei ist KI mehr als nur die großen Sprachmodelle (LLMs) wie z.B. ChatGPT oder MS Copilot, die von Benutzern mit Hilfe von Eingabeprompts im Browser bedient werden.

Künstliche Intelligenz (KI) bzw. Artificial Intelligence (AI) hat ihre Wurzeln in der Mitte des 20. Jahrhunderts. Methoden und Ansätze haben sich seitdem stark weiterentwickelt (von symbolischen Systemen über statistische Verfahren bis zu Deep Learning und Transformern). Der Bereich ist sehr datengetrieben und durch starke Dynamik und kurze Entwicklungszyklen gekennzeichnet.

Wir ➔ beraten zur passenden KI-Strategie und implementieren KI-Produkte der Unternehmen ➔ Microsoft und ➔ NFON sowie lokale LLMs.

Dabei setzen wir aktuelle Methoden und Vorgehensweisen der ➔ Wirtschaftsinformatik ein.

Auch die Schulung u.a. zur Formulierung von effektiven Eingabeprompts (Promptengineering) ist Teil einer geordneten KI-Einführung und wird von uns durchgeführt.

☏ +49 (40) 22616179-0

✉ info@cloud-contor.de

Was ist Intelligenz? – Definition, Merkmale und Unterschiede Mensch/KI

Intelligenz beschreibt die Fähigkeit, Informationen zu verarbeiten, Probleme zu lösen und sich an neue Situationen anzupassen. Beim Menschen umfasst sie Aspekte wie Kreativität, Emotionen, soziale Kompetenz und Erfahrungswissen.

Künstliche Intelligenz (KI) hingegen basiert auf Algorithmen und Daten. Sie erkennt Muster, lernt aus großen Datenmengen und führt Aufgaben präzise und effizient aus – jedoch ohne Bewusstsein oder Emotionen. Während menschliche Intelligenz flexibel und kontextsensitiv ist, bleibt KI auf die ihr vorgegebenen Ziele und Trainingsdaten beschränkt.

Der entscheidende Unterschied: Während Menschen bewusst, ganzheitlich und wertegeleitet denken, verarbeitet KI Kontext statistisch und zielgebunden - ohne eigenes Bewusstsein.

Unterschiede zwischen Intelligenz (deutsch) und Intelligence (englisch)

Obwohl die Begriffe „Intelligenz“ im Deutschen und „Intelligence“ im Englischen häufig synonym verwendet werden, gibt es Unterschiede in ihrer Bedeutung und Anwendung:

-

Intelligenz (deutsch): Im Deutschen steht „Intelligenz“ meist für die kognitive Fähigkeit, Probleme zu lösen,

Wissen zu erwerben und sich an neue Situationen anzupassen. Der Begriff ist eng mit messbaren geistigen Leistungen (IQ, Problemlösefähigkeit, Lernfähigkeit)

verbunden und wird überwiegend auf Menschen (und teilweise Tiere) bezogen. Typische Kontexte sind Psychologie, Pädagogik, Neurowissenschaften.

- Intelligence (englisch): Im Englischen ist „Intelligence“ ein weiter gefasster Begriff. Neben der kognitiven Leistungsfähigkeit bezeichnet er auch das Sammeln und Auswerten von Informationen (z. B. „➔ Business Intelligence“, „Military Intelligence“ oder „CIA - Central Intelligence Agency"). Im Kontext der Künstlichen Intelligenz („Artificial Intelligence“) steht der Begriff für die Fähigkeit von Maschinen, Aufgaben zu erledigen, die normalerweise menschliche Intelligenz erfordern.

Fazit: Während „Intelligenz“ im Deutschen stärker auf geistige Fähigkeiten abzielt, umfasst „Intelligence“ im Englischen auch Aspekte der organisierten Informationsverarbeitung und -beschaffung. Diese Unterschiede sind besonders relevant, wenn KI-Themen diskutiert werden und verdeutlichen die Notwendigkeit einer präzisen Begriffsklärung.

LLMs und stochastische Papageien

Stochastik ist ein Teilbereich der Mathematik, der sich mit Wahrscheinlichkeitstheorie und mathematischer Statistik beschäftigt.

Der Begriff „stochastischer Papagei“ beschreibt große Sprachmodelle (LLMs - Large Language Models) wie z.B. ChatGPT oder MS Copilot, die auf neuronalen Netzen basieren und Texte erzeugen, indem sie statistische Wahrscheinlichkeiten berechnen - ohne echtes Verständnis. Sie „plappern“ Muster aus Trainingsdaten nach, ähnlich einem Papagei, und wirken dadurch intelligent, sind aber rein probabilistisch (basierend auf Wahrscheinlichkeiten).

Das bedeutet:

- Antworten wirken sinnvoll, basieren aber nur auf Statistik

- Risiko von Fehlinformationen (Halluzinationen), Verzerrungen (Bias) und manipulativem Alignment (Zensur)

- Ethische Fragen werden aufgeworfen und Grenzen von KI müssen ausgelotet werden

Fazit: Ein „stochastischer Papagei“ ist kein denkendes System, sondern ein Werkzeug zur Mustererkennung und Textgenerierung. LLMs haben keine menschliche Intelligenz, sondern simulieren menschliche Intelligenz.

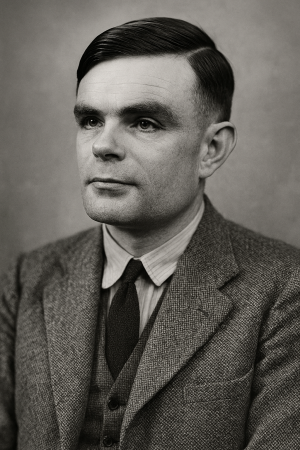

Geschichtliche Entwicklung der KI

Die Entwicklung der KI begann bereits in den 1950er Jahren mit ersten theoretischen Konzepten und späteren Expertensystemen. Wichtige Meilensteine sind:

- 1950: Alan Turing veröffentlicht den berühmten Artikel Computing Machinery and Intelligence und stellt den Turing-Test vor - ein Gedankenexperiment, um festzustellen, ob Maschinen „denken“ können.

- 1956: Erste KI-Konferenz in Dartmouth - der Begriff „Artificial Intelligence“ entsteht.

- 1960er-1970er: Joseph Weizenbaum entwickelt das Programm ELIZA, einen frühen Chatbot, der einfache Gespräche simuliert und die Diskussion über die Grenzen maschineller „Intelligenz“ anstößt.

- 1980er: Expertensysteme zur Entscheidungsunterstützung, vorwiegend in Medizin und Industrie.

- 2000er: Fortschritte im maschinellen Lernen durch größere Datenmengen und leistungsfähigere Hardware.

- Ab 2010: Durchbruch des Deep Learning mit neuronalen Netzen, KI-basierte Sprach- und Bilderkennung, autonome Systeme.

- 2017: Einführung der Transformer-Architektur - Grundlage für moderne Sprachmodelle.

- 2020er: Generative KI wird populär (ChatGPT als Meilenstein). Entwicklung von Generatoren für Text, Bild, Ton und Video sowie Bots und Agentensysteme.

ChatGPT, MS Copilot, lokale LLMs

So wie übergeordnet Schatten-IT (Nutzung von nicht autorisierten IT-Systemen an der regulären IT vorbei mit entsprechendem Datenabfluß) existiert, gibt es auch zunehmend Schatten-KI (Nutzung von nicht autorisierten LLMs mit Datenabfluß durch Befüllung von Eingabeprompts mit vertraulichen Unternehmensdaten). Beides ist eine Gefährdung der ➔ IT-Sicherheit von Unternehmen und ist daher zu minimieren.

Im Bereich der großen Sprachmodelle (LLMs - Large Language Models) bzw. der GPTs (Generative Pre-trained Transformer) gibt es verschiedene Ausprägungen bzw. Kategorisierungen, die sich u.a. im Hinblick auf die Vertraulichkeit unterscheiden.

Bei MS Copilot handelt es sich um eine ganze Familie von Produkten. Wir berücksichtigen hier nur die beiden Ausprägungen MS Copilot (Consumer) und MS Copilot für M365.

Die folgende Kategorisierung basiert vorwiegend auf dem unterschiedlichen Level von Vertraulichkeit und der Integration in andere Systeme. Die Systeme der Kategorien haben gemein, daß sie im Wesentlichen mit frei verfügbaren Daten aus dem Internet trainiert und dann feinabgestimmt werden.

Alle Kategorien haben Vor- und Nachteile, die im konkreten Einzelfall abgewogen werden müssen (➔ Beratung):

- Public-Cloud-LLMs (z.B. Open AI ChatGPT, MS Copilot (Consumer), Google Gemini, xAI Grok oder Anthropic Claude):

- Pro: Sehr benutzerfreundlich, sofort nutzbar; stets aktuelle Modelle; keine eigene Infrastruktur erforderlich.

- Kontra/Kritisch: (US-)Verarbeitung von Prompts/Antworten; Inhalte können vom Anbieter ggf. zu Trainingszwecken genutzt werden (auch bei deaktiviertem Chatverlauf nicht sicher ausgeschlossen).

- Wichtig: Keine vertraulichen oder personenbezogenen Daten eingeben, Trainings- und Verlaufseinstellungen prüfen (Opt-out); erhöhtes Risiko für Schatten-KI, Datenabflüsse und DSGVO-Verstöße.

- Public-Enterprise-Cloud-LLMs (z.B. MS Copilot für M365, OpenAI ChatGPT Enterprise, Google Gemini for Google Workspace oder Claude for Enterprise):

- Pro: Zugriff mit Rollen- und Rechteverwaltung; vertraglich zugesichert: Eingaben/Outputs werden nicht zum Training der Basismodelle verwendet; Microsoft: bei EU-Tenant erfolgt die Verarbeitung innerhalb der EU-Datengrenze. Speziell MS Copilot für M365: Nahtlose Integration in MS Word, MS Excel, MS Teams, MS Outlook & Co.

- Kontra/Kritisch: Daten werden in externen Rechenzentren verarbeitet; dadurch bleibt die vollständige Kontrolle über die Verarbeitung eingeschränkt. Ggf. gelten für den Anbieter außereuropäische (US-)Gesetze. Für besonders sensible Bereiche ist das oft nicht ausreichend.

- Wichtig: Nur Inhalte gemäß internen Schutzklassen/Policies verarbeiten; systematische Implementierung von ➔ IT-Sicherheit notwendig.

- Lokale LLMs (z.B. OpenAI GPT-OSS, MS Phi-4):

- Pro: Modelle laufen vollständig auf eigener Hardware oder in einer dedizierten Private Cloud; ➔ Datensouveränität - Inhalte bleiben in der eigenen Umgebung (bei strikt konfigurierter Offline-Verarbeitung); keine Abhängigkeit von (US-)Anbietern sowie geringes Risiko durch Cloud Act oder AGB-Änderungen; Finetuning und Anreicherung mit vertraulichen Dokumenten möglich.

- Kontra/Kritisch: Höherer Initialaufwand (Beschaffung/Setup, Pflege/Updates); Leistung unter den großen Public-Cloud-Modellen; TCO (Energie/GPU-Kosten) und Verantwortung für Sicherheit/Verfügbarkeit liegen vollständig intern; Skalierung und Betrieb sind anspruchsvoller als bei Public-Cloud-Modellen.

- Wichtig: Netzwerk-Härtung (keine Telemetrie/Outbound), Rollen-/Rechtekonzept, Logging & Audit, Kapazitätsplanung (GPU/VRAM, Speicher), Datenpipelines für vertrauliche Dokumente; regelmäßige Evaluation/Benchmarks und Patchmanagement notwendig.

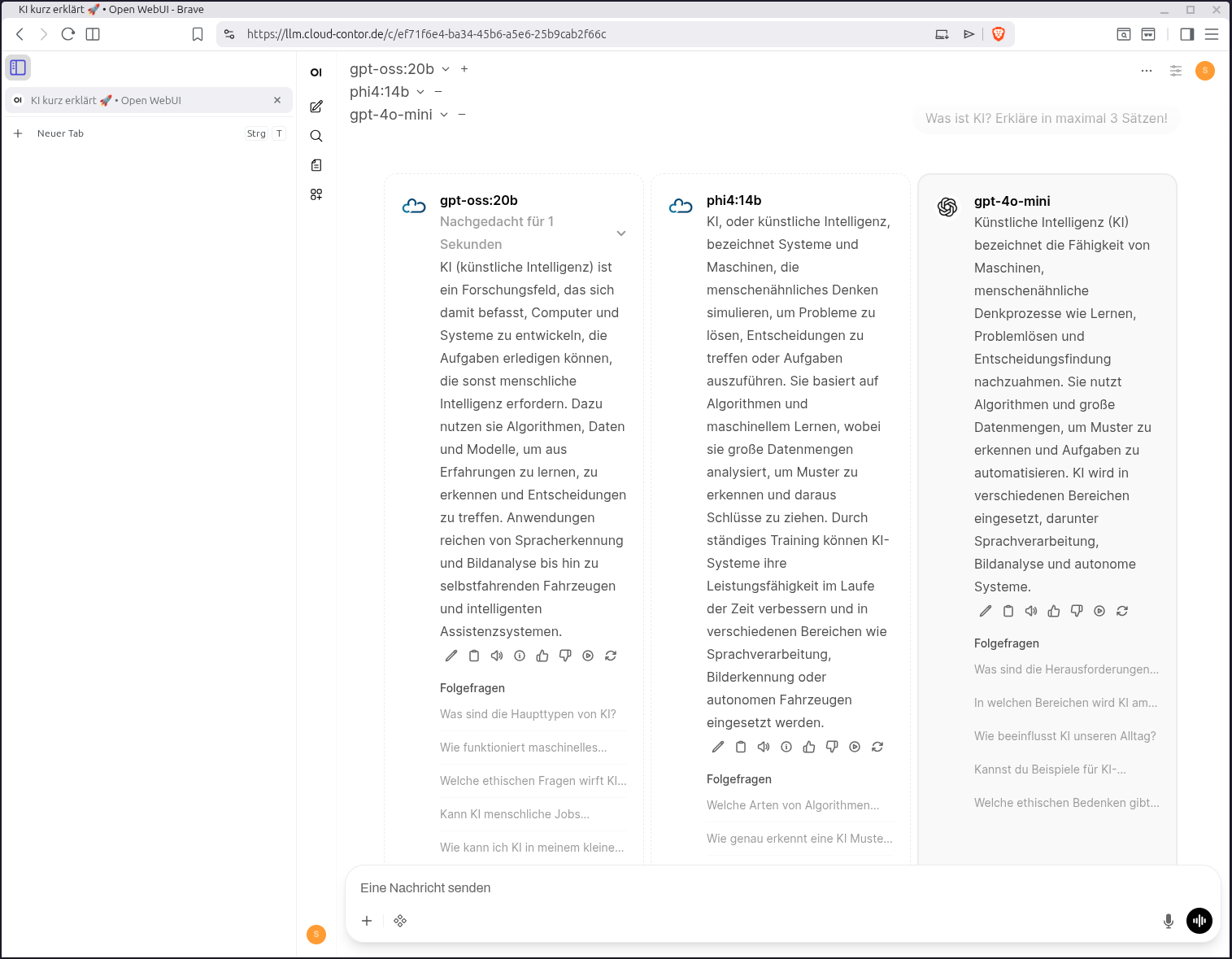

Wie kommt KI in die Unternehmen?

Der Einstieg von Unternehmen in KI erfolgt meist schleichend über Schatten-KI: Mitarbeiter nutzen ChatGPT & Co. privat und bringen die Tools dann „nebenbei“ ins Unternehmen ein. Dabei werden schnell vertrauliche Daten in Eingabeprompts kopiert und fließen so aus Unternehmen ab.

Eine geordnete Einführung sieht anders aus:

- Bestandsaufnahme & Risikoanalyse (Welche Daten dürfen wo hin? ➔ CheckIS Integrity)

- KI-Richtlinie im Unternehmen einführen (erlaubte Tools, Verbote, Schulungen) und in IT-Strategie einordnen

- Pilotprojekte mit klar definierten Anwendungsfällen (z. B. Telefon-/Sprachassistenz, Textoptimierung, Meeting-/Telefonattranskription, Zusammenfassungen, Wissensdatenbanken, Agentensysteme)

- Technische Umsetzung: Enterprise-Public-Cloud oder lokale LLMs je nach Sensibilität

- RAG-Architektur (Retrieval-Augmented Generation) aufbauen: Unternehmenseigene Dokumente werden in LLMs integriert, bleiben aber intern und werden zur Kontextverbesserung genutzt

- Kontinuierliche Schulung und Monitoring

Unternehmen, die diesen strukturierten Weg gehen, nutzen KI als Wettbewerbsvorteil statt vor ihr als Sicherheitsrisiko zurückzuschrecken.

Um schnelle Umsetzungserfolge zu erreichen, können „Low Hanging Fruits“ geerntet werden, also Lösungen, die unmittelbar „aus dem Regal“ gezogen werden können (ersetzt nicht das strukturierte Vorgehen).

Beispiele:

- Als ➔ Microsoft-Partner können wir

direkt MS Copilot einrichten. Mit der Einrichtung des ersten Benutzers wird ein semantischer Index aufgebaut. Nach Erstellung des Index

können die lizensierten Benutzer Anfragen zu allen Daten stellen, die mit ihren Zugriffsrechten im M365-Tenant erreichbar sind, inkl. MS SharePoint und MS OneDrive.

- Als ➔ NFON-Partner haben wir Zugriff auf KI-Lösungen im Telefoniebereich

und können sie direkt für unsere Kunden buchen (Transkription von Mailboxnachrichten in Text und Zustellung per Mail,

virtuelle Telefonzentrale inkl. Vermittlung von Anrufen je nach inhaltlichem Anliegen, weitere KI-Assistenzfunktionalität).

KI bei Cloud Contor

Der Bereich Künstliche Intelligenz (KI) ist durch starke Dynamik und kurze Entwicklungszyklen gekennzeichnet. Wir sind bemüht, mit den Entwicklungen Schritt zu halten und die soliden Methoden und Vorgehensweisen der ➔ Wirtschaftsinformatik einzusetzen.

KI ist stark datengetrieben. Das kommt unseren ➔ Wurzeln im Bereich Datenbankentwicklung und ➔ Business Intelligence sehr entgegen.

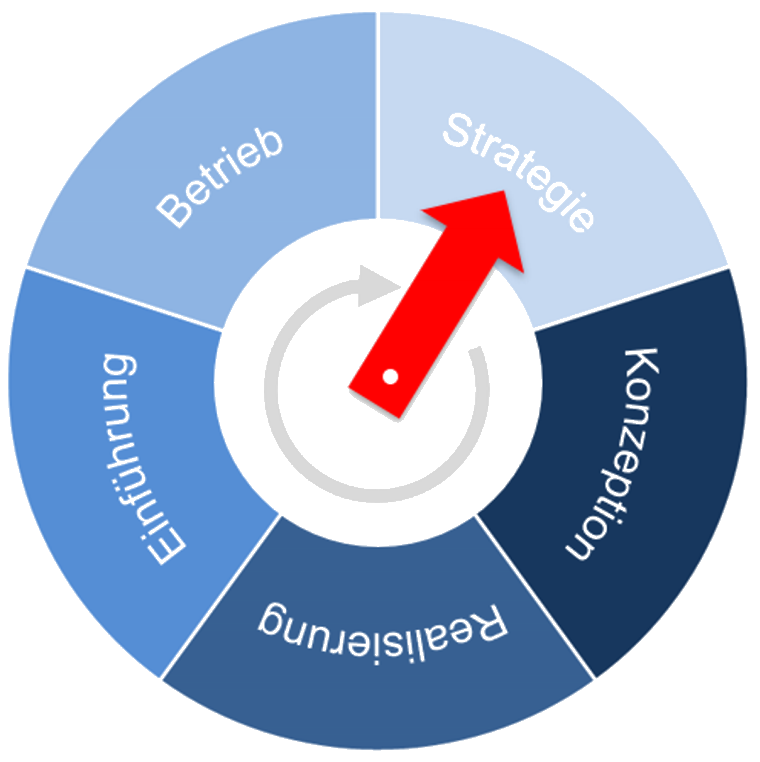

Wir bieten an:

- ➔ Individuelle Beratung zur passenden KI-Strategie

- Implementierung von KI-Produkten der Unternehmen ➔ Microsoft und ➔ NFON

- Aufbau von privaten KI-Instanzen (GPT-OSS, MS Phi4, Llama 3, Mistral etc.) auf dedizierter Hardware oder in abgeschotteten Private-Cloud-Umgebungen

- RAG-Lösungen mit Ihren eigenen Dokumenten und hoher Datenschutzkonformität

- Integration in bestehende Systeme (Nextcloud, Microsoft 365, CRM, ERP)

- Schulungen und Workshops für Mitarbeiter und IT, z.B. zum Thema Formulierung von effektiven Eingabeprompts (Promptengineering)

- Laufende Betreuung und Weiterentwicklung Ihrer KI-Landschaft